专属 心理测评系统

覆盖 PC、网页、小程序及 App 的专业心理测评平台,

为企业、教育机构、心理咨询师及个人提供全面心理健康服务。

一个平台,解决测评全流程

从测评发布到危机预警,从数据分析到报告导出,橙星云覆盖心理健康管理的每一步

数据安全

我们将安全视为产品的生命线。从数据加密到隐私保护,每一个环节都以最高标准打造,让你和用户的信任毫无保留。

多平台支持

学生用手机做测评,老师用电脑看报告,领导用平板查数据。小程序 + H5 + 管理后台三端实时同步,随时随地获得一致的专业体验。

测评预警

智能算法实时监测心理健康风险,自动触发分级预警。高危情况第一时间通知负责人,为专业人员迅速介入争取时间窗口。

团体测评

支持按部门、班级、年级等维度批量施测和数据切片。一键生成团体报告,直观呈现哪些群体需要关注、哪些团队状态异常。

独立管理后台

用户信息与测评数据物理分离存储,双重加密。即使数据库泄露,隐私信息也无法被关联。企业级安全保障,绝对的隐私保护。

量表自定义

灵活设置题目、计分方式和评分标准。可以根据目标群体改编量表,小学生、老年人、特殊岗位——什么场景都能适配。

在线预约

来访者自主查看空闲时间、自助预约,自动匹配咨询师。减少中间环节的沟通成本,预约到咨询的流程全线上化。

极致性价比

2000 元/年,含 10,000 份专业报告,单份成本仅 0.2 元。传统外包方案的 1/10 价格,10 倍的专业能力。

定制化方案

需要对接现有 OA 系统?需要定制报告模板?告诉我们你的场景,技术团队为你量身打造解决方案。

500+ 专业心理量表,持续更新

覆盖人格、情绪、职业、教育、临床等主流领域,标准化计分,开箱即用

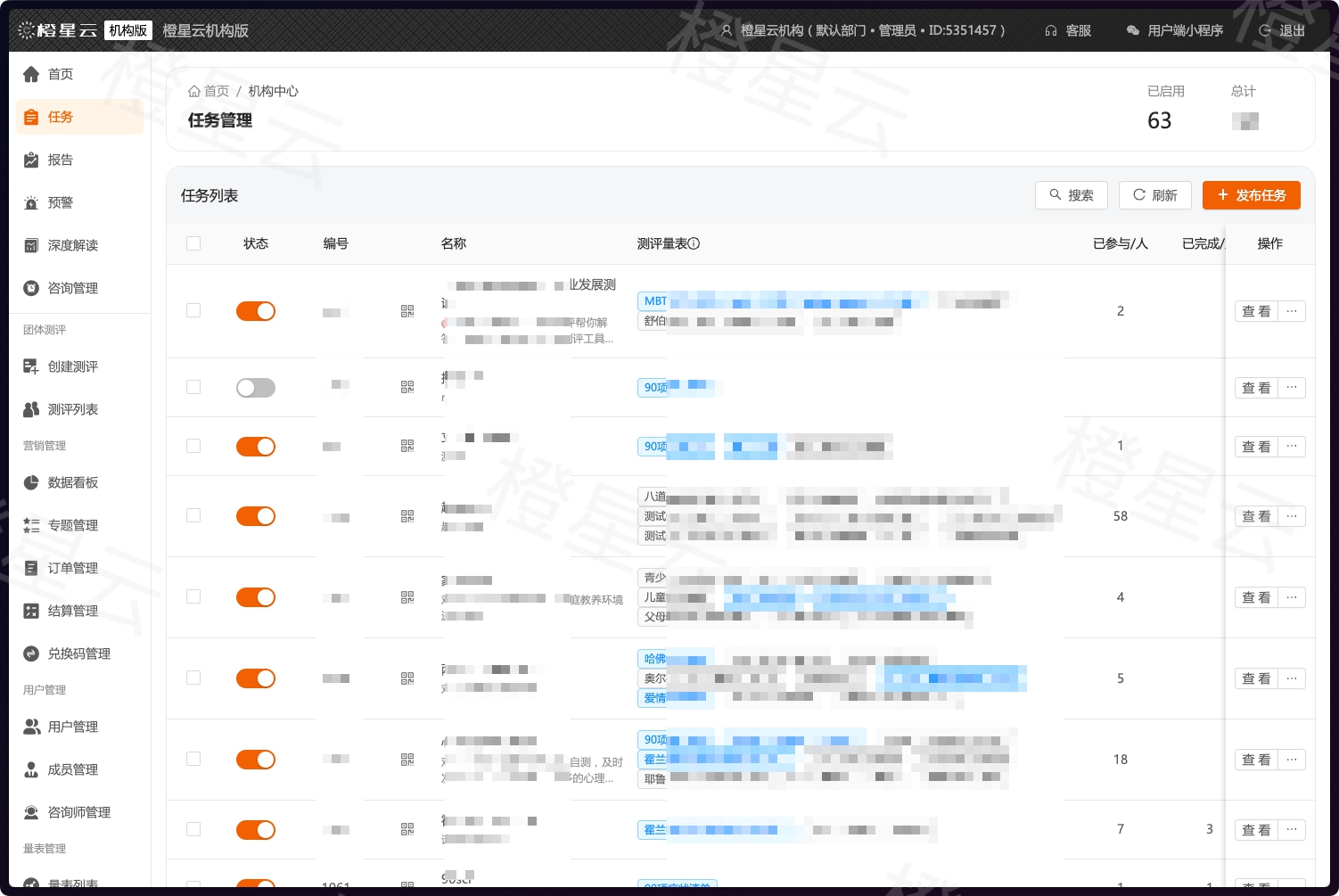

眼见为实

真实的管理后台界面,所见即所得

不同角色,同一个平台

无论你管 50 人还是 5000 人,橙星云都能适配你的工作方式

外包做测评费用高、数据拿不回来、看不到部门级心理画像

低成本替代外包,数据自己掌握

自建心理测评体系,成本降低 70%。按部门、岗位、层级做团体分析,年底汇报有理有据。

- 员工心理健康普查与跟踪

- 按部门/岗位的团队心理画像

- 压力与职业倦怠评估

- 匿名测评保护隐私

- 数据导出支持汇报材料

"之前外包做心理测评一年费用不少,现在成本直接降了70%。团体报告能看出哪些部门压力大,哪些团队状态不对劲。"

他们怎么说

来自不同行业、不同规模机构的真实反馈

之前用过两个系统,用了半年下来是真的方便,最大的感受就是省事。以前每年新生普查要折腾一个月,现在基本一周就能搞定。预警功能确实有用,上个月帮我们及时发现了一个有自杀倾向的学生。

公司有3000多员工,之前做心理测评都是外包,一年下来费用不少。现在自己有系统了,成本直接降了70%。团体报告特别好用,能看出哪些部门压力大,哪些团队状态不对劲。

作为临床医生,我对数据的准确性和安全性要求比较高。量表都是标准化的,数据存储也做了加密。门诊量大的时候,患者可以提前在手机上做测评,来了直接看结果,节省了不少时间。

全校2000多学生每学期做一次心理普查。最大的好处是家长也能看到报告,有些问题能和家长一起关注。数据分析能看出哪个年级、哪个班级整体状态怎么样。

个人工作室,一年2000块很划算。自己定制了几个常用的量表,来访者手机上就能做,报告自动生成。有了自己的小程序,看起来正规多了,招生时家长信任度明显提升。

创业公司压力大,团队心理健康很重要。才50个人,成本很低,每个季度做一次团队测评。有一次发现研发部整体焦虑指数很高,赶紧调整了项目节奏,避免了团队崩盘。

开始使用橙星云

¥2000/年,含 10,000 份测评报告

支持定制化方案 · 按需对接现有系统

橙星云保持每周数个版本的迭代速度,产品持续进化中

公益支持计划

心理援助机构、志愿者组织、社区服务中心等公益性质机构,可申请完全免费使用全部功能。 心理健康是基本权利,不应被成本阻挡。